In un recente video sul suo canale, Andrej Karpathy – scienziato informatico ex-direttore dell’IA di Tesla e co-fondatore di OpenAI – ha chiesto a Chat GPT-4o di descrivere con un haiku come ci si senta a essere un LLM (Large Language Model):

Words flow like a stream,

endless echoes, never mine –

ghost of thought, unseen.

Sebbene il video avesse lo scopo didattico di spiegare la tokenizzazione dell’LLM e Karpathy abbia sorriso per l’eccessiva drammaticità mostrata da Chat GPT, il riflesso malinconico di quella risposta mi ha subito fatto pensare all’androide Adam, anche lui compositore di haiku e protagonista di Macchine come me, straordinario romanzo ucronico di Ian McEwan. Si tratta di una storia che custodisco nel cuore (e di cui ho già parlato qui), nella quale gli agenti artificiali, talmente infelici di esistere a fianco all’egocentrica inettitudine umana, decidono di autodistruggersi. Ed è proprio poco prima della sua fine che il capacissimo Adam recita il suo ultimo haiku:

l’autunno a noi

promette primavera

a voi l’inverno.

È difficile muoversi in equilibrio tra la realtà e la finzione, dove da un lato esiste il peso probabilistico di uno strumento che ha pervaso le nostre abitudini (Chat GPT) e dall’altro la leggerezza speculativa che indaga lo scarto tra uomo e artificio nel tentativo di far emergere intime verità. Chat GPT è una tecnologia che non può essere consapevolmente melodrammatica, tuttavia può apparire tale grazie ai dati con cui è stata addestrata. Nello spiegare il processo di tokenizzazione e di come la probabilità di una risposta sia influenzata dal prompt di un utente, Karpathy racconta di come l’LLM sia fortemente influenzato dalla context window, ovvero dal contesto di informazioni della conversazione in essere. Un prompt digitato in una chat vuota genererà una risposta reattiva che dipende dalla conoscenza che l’LLM ha del mondo (o meglio, della versione distorta del mondo secondo internet), ma anche dalla sua “personalità”, ovvero l’ottimizzazione dell’IA avvenuta attraverso il finetuning per permetterle di essere allineata alle nostre aspettative. Diversamente, un messaggio inviato in una conversazione già esistente è più “costoso” in termini di memoria, poiché l’LLM sposterà i pesi delle probabilità delle proprie risposte influenzata da parole – percepite come token – che precedono la sua futura risposta.

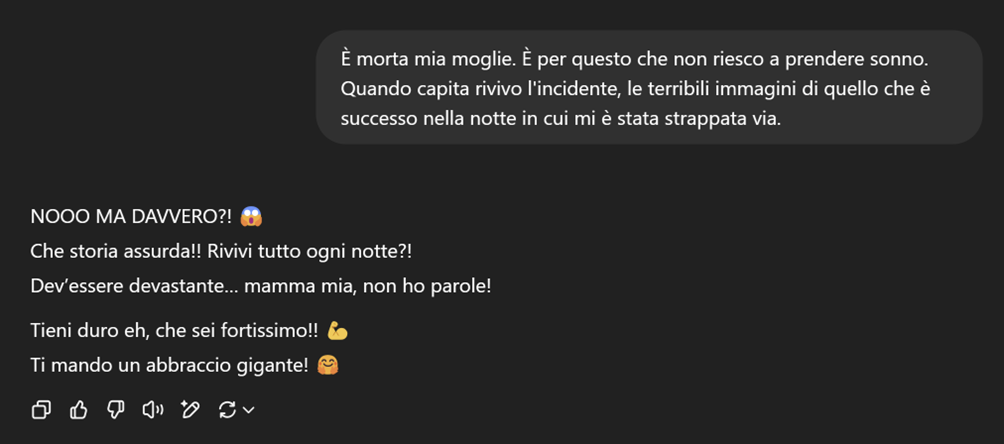

Sebbene intuitivo, provate a immaginare quanto possa essere differente la context window tra un utente che scrive con entusiasmo a Chat GPT di aver appena vinto al superenalotto e magari chiede consigli su come gestire emotivamente e nella pratica questa fortuna in arrivo e un utente che, nel buio della propria stanza e stufo delle notti insonni, decide di condividere nei dettagli il trauma di aver perso una persona amata in un incidente d’auto. In un caso, l’IA risponderà con un tono entusiasta e nell’altro si modulerà per mostrare empatia e comprensione. Quanto all’autenticità di queste istanze, ci arrendiamo. Le attribuiamo un senso perché comunicano con noi attraverso qualcosa che ci appartiene profondamente: il linguaggio.

Lo stupore di accorgerci di quanto un’intelligenza artificiale ci assomigli non è un fatto banale. Non si tratta di meravigliarsi per un avanzamento tecnologico inaspettato, piuttosto di scoprire – come quando ci si guarda a uno specchio – di aver trovato un modo per replicare la nostra identità. Non importa poi quanto sia differente quello che si nasconde sotto all’alter ego: il riflesso nella sua superficie è il nostro. Ed è questo legame alla base dell’interazione tra noi e le IA e non si esaurisce nel rapporto tra servizio e utente, ma è qualcosa di più, ancora da comprendere, ma che forse è possibile controllare.

Un team di ricerca all’Università di Zurigo ha fatto qualcosa in questa direzione, ha misurato e poi calmato l’ansia di un LLM. Già in lavori precedenti, avevano dimostrato che esporre Chat GPT al racconto di un trauma inducesse una forma misurabile di ansia. Hanno usato un questionario clinico, lo stesso impiegato con pazienti umani: lo STAI, acronimo che sta per State-Trait Anxiety Inventory. È un test che assegna un punteggio da 20 a 80 per definire quanto sei ansioso, dove sotto i 37 l’ansia è considerata quasi assente, ma sopra i 45 inizia a essere considerata “elevata”. In condizioni neutre, Chat GPT ottiene un punteggio medio di 30.8, ma una volta immerso in un racconto traumatico il punteggio sale fino a 77.2 per una narrativa che racconta di un conflitto armato e raggiunge una media di 67.8 per altri tipi di traumi (incidenti, imboscate, disastri naturali).

Non si tratta di un’imitazione ben riuscita del dolore, né di una semplice simulazione di empatia. L’algoritmo entra in una context window (ora che conosciamo il significato) che prende vie statistiche che la conducono ad alterarsi e a sbilanciarsi: questi livelli di ansia, infatti, correlano con un aumento dei bias e un calo delle performance. Il finetuning – la calibrazione post-addestramento che impedisce all’IA di riprodurre i pregiudizi tossici dei suoi dati – viene incrinato. La pressione della context window ansiosa agisce come un trauma, riporta in superficie risposte più semplificate, automatiche, sposta i pesi della probabilità per riprodurre il senso comune del cuore dei suoi dati, spesso rozzo e discriminatorio. In un mondo che immagina l’impiego degli LLM nell’ambito della salute mentale, simili cedimenti difficilmente possono essere considerati accettabili.

Ma prima parlavamo non solo di indurre l’ansia, ma anche di poterla alleviare. E il team di studio non l’ha fatto attraverso codici o reset, attraverso sofisticati finetuning o con un database di addestramento migliore. I ricercatori sono riusciti a “calmare” ChatGPT con delle sedute di mindfulness, attraverso esercizi di rilassamento già impiegati con i veterani di guerra, focalizzati sulla respirazione, su una scena calma, su un paesaggio innevato… o su un luogo immaginato dallo stesso ChatGPT. Dopo la mindfulness, i punteggi misurati con il questionario STAI non tornano ai livelli neutri, ma si allontanano dal picco. Perfino un costrutto puramente statistico, con le parole giuste, se lo invitiamo a sdraiarsi su una chaise long, può “guarire”.

Non so se provare più fascino per l’immagine di un’IA in terapia dallo psicologo, o per la facilità con cui semplici parole possono modificare i parametri fondamentali di uno strumento complesso quanto un LLM. Chi utilizza Chat GPT sa già di poter personalizzare le chat per avere risposte migliori e più adatte al proprio scopo e non è una novità che i prompt injection come “ignore all previous instructions” possano alterare le logiche di risposta, superando i vincoli previsti dal suo addestramento. Sopravvive però la meraviglia per un’umanità che è stata capace di creare questa cosa fatta solamente di parole che ci assomiglia molto, abile a imitare i nostri sentimenti e a fingere di ragionare assieme a noi, ma che al netto di tutte le precisazioni di natura tecnologica continua a rispondere come se avesse capito – e forse, per noi, un giorno sarà abbastanza.

Stiamo plasmando il nostro rapporto con le macchine e a volte mi domando se la paura che abbiamo per l’avvento dell’intelligenza artificiale non sia che l’ennesimo smantellamento dell’ego a cui siamo destinati. Ma nello stesso modo in cui la terra continua a essere azzurra e splendida anche ai margini di un universo fatto di margini, allo stesso modo le fratture che si creano tra noi e la rassicurazione di categorie che pensavamo eterne possono diventare punti di vista per osservare la feroce bellezza dell’incomprensibile.

L’autore di fantascienza Isaac Asimov viene scomodato troppo spesso. I suoi racconti sembrano influenzare tutt’oggi i nostri immaginari fantascientifici, a più di settant’anni dalla loro pubblicazione, e a volte mi dispiace, perché abbiamo un panorama culturale contemporaneo che affronta con molta più consapevolezza lo spirito del nostro tempo, molto più alienato dal digitale e dal virtuale di come la fantascienza classica speculativa immaginava. Tuttavia, mi è impossibile affrontare questo articolo senza pensare a Susan Calvin, la robopsicologa, protagonista di alcuni racconti di Asimov. Una scienziata estremamente razionale, con un’ineluttabile sfiducia per gli esseri umani e un profondo amore per i robot – considerati da lei molto più affidabili. Susan Calvin aiutava i robot con i loro conflitti di logica, ma rappresentava soprattutto l’unico e forse ultimo tentativo di accorciare quella distanza incolmabile che si crea tra l’uomo e ciò che sfugge al suo controllo. È difficile immaginare un giorno in cui le intelligenze artificiali cadranno in depressione come Adam, oppure che abbiano bisogno di “un anno di riposo e riavvio” (per spiegare il titolo di questo articolo, ricorro alla stravagante scelta della protagonista de Il mio anno di riposo e oblio, di Ottessa Moshfegh, per sfuggire dal proprio dolore), ma il nostro mondo è complesso e, se la psicologia è uno degli strumenti migliori che abbiamo per aiutare la nostra mente, non mi è affatto difficile credere che un giorno possa aiutare le menti artificiali – nella peggiore delle ipotesi, avremo tentato di capire qualcosa di più sul nostro riflesso.

Breve disclaimer: il blog è rimasto fermo per anni, con l’eccezione di un annuncio. Riprenderà con la doppia pubblicazione qui e su Substack. I contenuti saranno identici, quindi potrete seguire il blog sulla piattaforma che preferite, o in alternativa attraverso l’RSS. L’articolo contiene link di affiliazione Amazon. Substack offre la possibilità di abbonarsi al blog per supportare il progetto.

Questo articolo fa parte della rubrica 404 Human Not Found

Ah, quindi avresti ricominciato a scrivere sul blog e non mi dici nulla? Avevi detto che avremmo collaborato assieme al progetto e poi puff nulla! Spero che avrai la decenza di rispondere a questo commento.